728x90

- 데이터 불균형이 심한 경우 Accuray를 평가지표로 삼지 않는다

Accuracy = (TP+TN) / (TP+FP+FN+TN)

- 객체인식 데이터의 경우 데이터 불균형이 심한 편이다

- Precision, Recall(Sensitivity), F1 score의 대안이 있다.

Precision = TP/(TP+FP)

Recall(Sensitivity) = TP/(TP+FN)

F1 score = 2(Precision×Recall)/(Precision+Recall)

- Precision과 Recall(Sensitivity)은 (항상 그런 것은 아니지만) trade-off 관계가 있기 때문에 F1 score를 사용한다

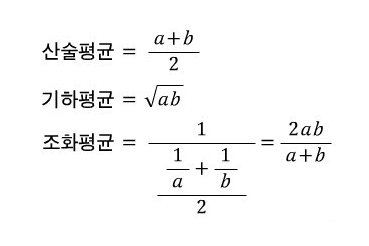

- F1 score를 계산 시 Precision과 Recall(Sensitivity)의 산술평균이 아닌 조화평균을 사용한다

- 조화평균은 항상 산술평균보다 작거나 같다. Precision과 Recall(Sensitivity)이 각각 50일 때와, Precision은 100, Recall(Sensitivity)은 0일 때 모두 산술평균은 50이다. 그러나 후자의 경우는 전자인 경우보다 모델의 성능이 더 좋지 않은 경우인데 산술평균은 이를 반영하지 못하는 것이다. 따라서 이때 후자의 경우에 조화평균을 사용한다면 F1 score는 0으로 계산된다. 따라서 조화평균이 산술평균보다 모델의 성능을 더 잘 표현할 수 있다.

'AI > Machine Learning' 카테고리의 다른 글

| mAP를 알아보자(간단 명료 설명) (0) | 2023.09.14 |

|---|---|

| [펌] [이석중의 알기쉬운 인공지능] 과적합(overfitting) 해결 방법: regularization (0) | 2021.10.22 |

| light gbm, xgboost 예제 코드 및 하이퍼파라미터 튜닝 (0) | 2021.09.17 |

| [펌] 파이썬 데이터 스케일링(정규화, 표준화) 관련 조언, 방법 (0) | 2021.07.21 |

| 파라미터와 하이퍼 파라미터의 공통점과 차이점 (0) | 2021.06.21 |